设置网站的robots文件

搜索引擎通过一种程序“蜘蛛”(又称 spider),自动访问互联网上的网页并获取网页信息。您可以在您的网站中创建一个纯文本文件 robots.txt,在这个文件中声明该网站中不想被蜘蛛访问的部分,这样,该网站的部分或全部内容就可以不被搜索引擎访问和收录了,或者可以通过 robots.txt 指定使搜索引擎只收录指定的内容。搜索引擎爬行网站第一个访问的文件就是 robots.txt。

引自百度百科——robot.txt

作用

那么这个文件有什么用呢,他的用处其实并不体现在网站的实际建设中,而是 SEO 中的一环。

所谓的 SEO 就是指搜索引擎优化。对于用户来说,这个文件可以避免蜘蛛爬取收录不必要的页面,所以还是有些用处的。

生成方式

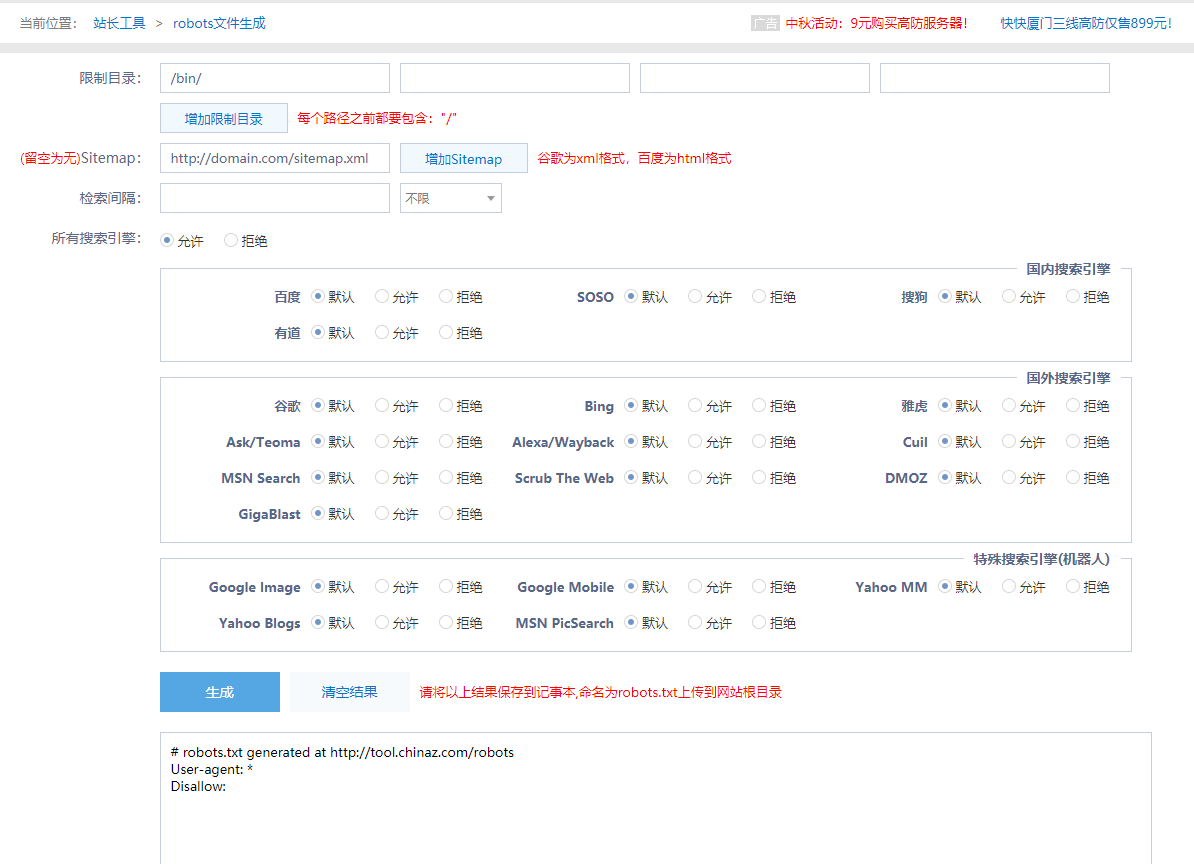

虽然可以直接手写文件,不过也有比较方便的工具可以更简便的生成这个文件。

通过站长工具的robots 文件生成工具就可以简单快速生成文件。

参考文章

Typecho 的 robots 文件